Notre contribution en soutien à la future réglementation européenne sur l’IA

Une approche à trois niveaux

On peut analyser l’approche européenne sur l’intelligence artificielle de confiance comme constituée de trois niveaux.

La réglementation est le niveau supérieur : applicable à long terme, elle pose des exigences que les systèmes d’IA, notamment ceux qualifiés à haut risque, doivent satisfaire pour pouvoir être déployés au service des citoyens européens : transparence, traçabilité, robustesse, précision, contrôlabilité, etc.

Au niveau intermédiaire, les normes harmonisées, dont le développement a été confié à l’organisation CEN/CENELEC, préciseront la manière dont les exigences de haut niveau de la réglementation seront traduites en exigences concrètes pour les systèmes d’IA que les organisations devront mettre en œuvre et qui seront éventuellement vérifiées par des tierces parties (« notified bodies »).

Les normes harmonisées contiendront des exigences sur le processus de conception, de dévleoppement et de supervision des systèmes, ainsi que sur les produits « systèmes IA » eux-mêmes. Le troisième niveau est donc celui de la mise en œuvre concrète des exigences, et notamment des outils et méthodes permettant de les réaliser. C’est à ce niveau que se situent les contributions du programme Confiance.ai, dont le sujet est justement la fournitude de méthodes et d’outils pour améliorer la confiance envers les systèmes d’IA pour des applications critiques. Les outils et méthodes produits par Confiance.ai visent d’abord les systèmes critiques, mais par extension peuvent être mis au service de tous systèmes d’IA quel que soit leur niveau de risque.

Des contributions technologiques

Les apports technologiques de Confiance.ai à la réglementation européenne concernent principalement trois exigences, matérialisées dans trois des dix demandes de normes faites au CEN/CENELEC par la Commission Européenne :

- la robustesse, soit la capacité du système à réaliser la fonction prévue en présence d’entrées anormales ou inconnues. Confiance.ai a produit et testé une vingtaine de composants logiciels sur ce sujet.

- L’exactitude (accuracy) : mesure quantitative de l’ampleur de l’erreur de sortie du système d’IA. Une dizaine des composants testés et réalisés dans le cadre de Confiance.ai sont pertinents pour améliorer l’exactitude ou la précision des systèmes.

- La qualité des données : la mesure dans laquelle les données sont exemptes de défauts et possèdent les caractéristiques souhaitées pour l’application visée. Sur ce sujet également, Confiance.ai a produit et évalué une dizaine de composants ainsi qu’une plate-forme spécifique rassemblant diverses approches permettant d’améliorer la qualité des données d’entrée des systèmes d’apprentissage automatique.

Ces outils sont référencés dans le catalogue produit par confiance.ai, et plusieurs d’entre eux en open source, y sont disponibles en téléchargement.

Les contributions technologiques de Confiance.ai ne s’arrêtent pas à ces trois propriétés : nous avons également des contributions sur d’autres exigences de la réglementation, traduites dans des demandes de normes européennes harmonisées : sur l’explicabilité (correspondant aux besoins de transparence et de compréhension des systèmes d’IA par les humains) ; sur la cybersécurité des systèmes d’IA, notamment par le tatouage des productions des systèmes d’IA – images ou autres contenus; et plus généralement sur la maîtrise des risques et l’analyse de conformité. Là aussi, tous les composants logiciels sont référencés dans le catalogue en ligne et certains sont téléchargeables.

Des contributions méthodologiques

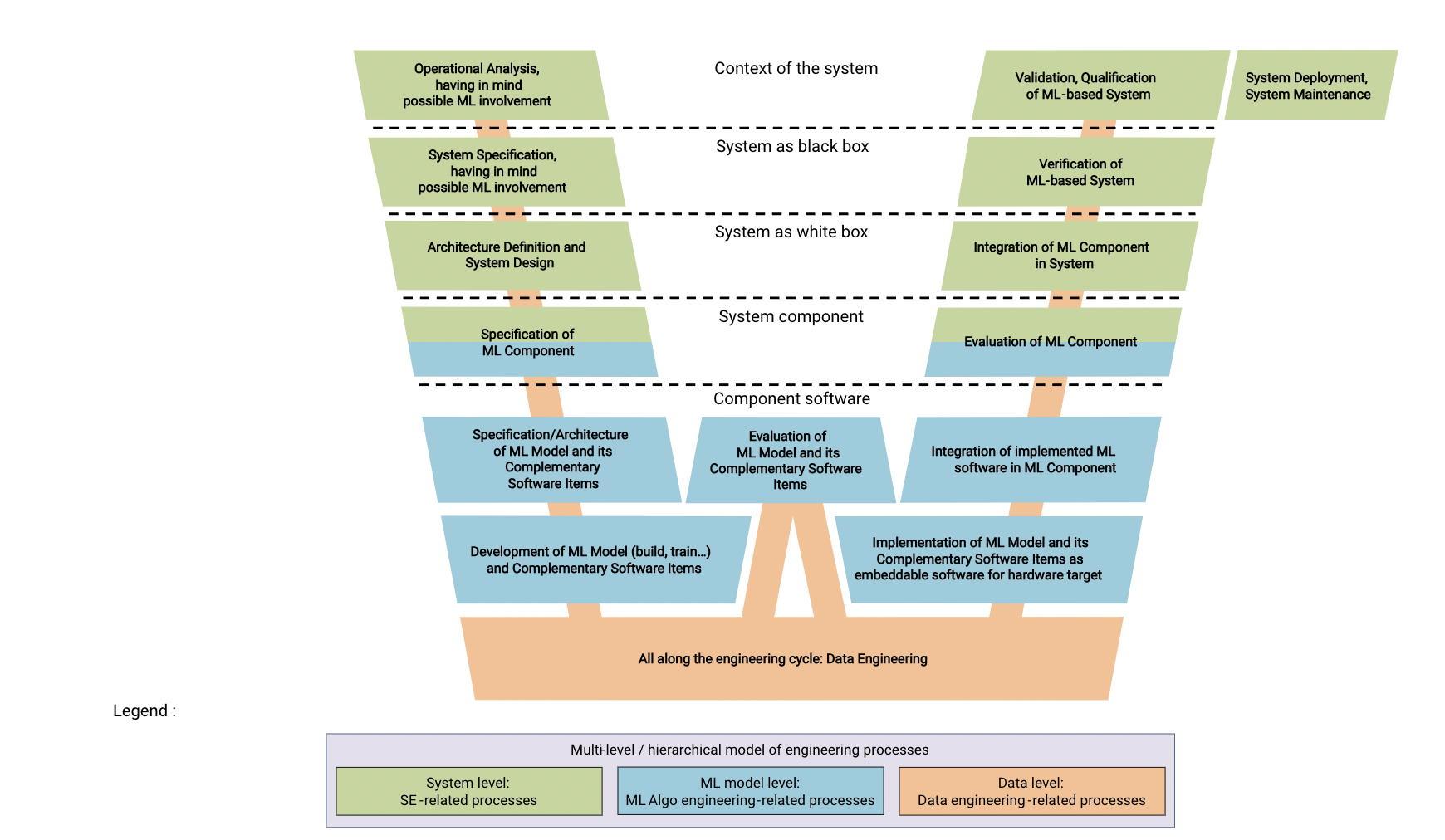

Les contributions méthodologiques de Confiance.ai portent sur le processus de développement d’un système d’IA, qui va de la spécification initiale et la conception jusqu’à la mise en service et la supervision de son fonctionnement, y compris dans des systèmes embarqués. Ces contributions sont multiples :

- une taxonomie des concepts et termes utilisés pour l’IA de confiance ;

- une documentation complète du processus, comprenant une modélisation des activités et des rôles, avec les éléments permettant aux ingénieries des entreprises de le mettre en œuvre ;

- et un « corpus de connaissances », le Body of Knowledge, qui regroupe l’ensemble de ces éléments et les rend accessibles sur le site web du même nom.

Si l’utilisation de ces outils méthodologiques n’est pas à elle seule une garantie de la conformité du système d’IA à la réglementation, elle peut en constituer un élément de justification, considéré comme faisant partie de l’état de l’art par les tierces parties (notified bodies) en charge de la vérification.

Figure 1 : Cycle de vie de l’ingénierie des systèmes et de l’ingénierie logicielle

Des contributions directes aux normes

Enfin, Confiance.ai a été impliqué, dès le début, dans les groupes de travail créés pour produire les normes harmonisées européennes, présentées ci-dessus comme le deuxième niveau de l’approche. Nous avons ainsi

- Fourni des éléments sur la taxinomie de l’IA de confiance et sur une vision de l’ensemble des attributs contribuant à la confiance envers un système d’IA ;

- Soumis une contribution originale sur la définition et l’utilisation de la notion de domaine d’emploi (operational design domain) qui pourrait être intégrée aux normes européennes et internationales ;

- Participé activement au groupe de travail chargé de produire la norme européenne sur la maîtrise des risques de l’IA, notamment par la rédaction d’un catalogue de sources de risques et des réponses connues dans la littérature ;

- Enfin, notre action de soutien à diverses démarches de labélisation de produits d’IA et d’entreprises concevant des produits d’IA, est clairement en relation avec la réglementation à venir puisque les futurs labels se baseront également sur cette réglementation.

Les industriels membres de Confiance.ai sont convaincus de la nécessité d’améliorer la confiance envers les systèmes d’IA notamment dans le cadre de systèmes critiques mettant en jeu la santé et la sécurité des personnes et des biens. Cette conviction est en phase avec les objectifs de la future réglementation européenne sur l’IA ; Confiance.ai matérialise cette ambition en développant et évaluant un ensemble d’outils et de méthodes ainsi qu’en participant à la démarche en cours d’établissement de normes à cet effet.